作者: 兆光科技 發(fā)布時間: 2024/08/09 點擊: 9959次

自從生成(chéng)式AI以勢如破竹的速度席卷幾乎每一個領域,AI挑戰人類的擔憂也越來越真實。

上次,馬斯克就人工智能(néng)研究界和産業界的大佬們一起(qǐ)發(fā)布了一篇呼籲暫停半年AI大模型訓練、加強AI技術監管的公開(kāi)信,呼籲全球所有實驗室暫停比更強的AI模型研發(fā),暫停時間至少爲6個月。但結果被(bèi)人扒出其實他爲Twitter購買了1萬個GPU用于推進(jìn)一個全新的AI項目,極有可能(néng)正在開(kāi)發(fā)自家的大語言模型。

但這(zhè)一次,又一封呼籲人們要重視AI帶來威脅的公開(kāi)信又發(fā)出。比上一次更引人注目的是,目前生成(chéng)式AI領域鼎立的三大巨頭: OpenAI 、DeepMind(隸屬于Google)、Anthropic都(dōu)加入其中。

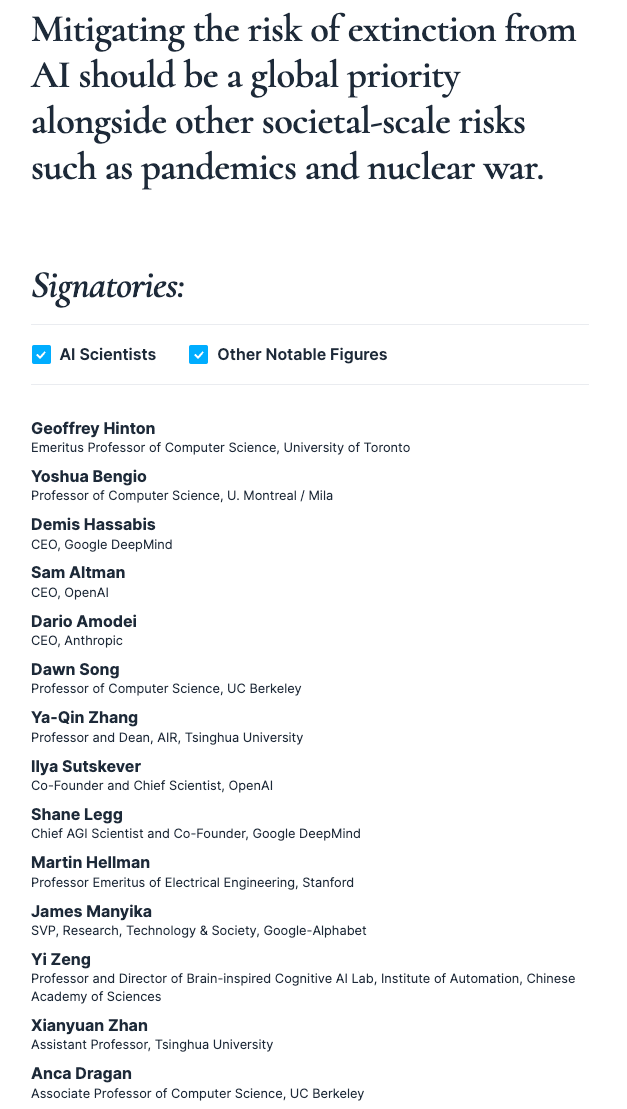

這(zhè)份聲明由總部位于舊金山的非營利組織AI安全中心發(fā)布,就他們認爲AI對(duì)人類構成(chéng)的生存威脅發(fā)出了新的警告。整份聲明才22個字——對(duì),你沒(méi)看錯,才22個字,全部内容如下:

減輕 AI 滅絕的風險,應該與管控流行病和核戰争等其他社會級規模的風險一樣(yàng),成(chéng)爲一項全球優先事(shì)項。

盡管AI威脅論并不新鮮,但如此直白地把它和“核戰争”、“大流行病”等危害全體人類的危機因素列在一起(qǐ)公開(kāi)作比較,還(hái)是屬于首次。

聲明的署名部分比聲明的内容長(cháng)得多。

除去OpenAI首席執行官Sam Altman、DeepMind首席執行官Demis Hassabis和Anthropic首席執行官Dario Amode以外,超過(guò)350名頂級AI研究人員、工程師和創業者也加入其中,包括曾經(jīng)獲得圖靈獎的“AI三巨頭”之二Geoffrey Hinton和 Yoshua Bengio,但另一位和他們一起(qǐ)獲獎的、現任Facebook母公司Meta首席 AI 科學(xué)家的Yann LeCun尚未簽名。

此外,名單裡(lǐ)還(hái)出現了中國(guó)學(xué)者的身影,包括中國(guó)科學(xué)院的自動化研究所人工智能(néng)倫理與治理研究中心主任曾毅,清華大學(xué)副教授詹仙園等。

完整簽名名單,可以在這(zhè)裡(lǐ)進(jìn)行查看:https://www.safe.ai/statement-on-ai-risk#open-letter

聲明發(fā)布者AI安全中心的執行主任Hendrycks表示,這(zhè)一份聲明很簡潔,特意沒(méi)有提出任何減輕人工智能(néng)威脅的潛在方法,就是爲了避免分歧。“我們不想推動包含30種(zhǒng)潛在幹預措施的龐大措施組合,”Hendrycks說。“當這(zhè)種(zhǒng)情況發(fā)生時,它會淡化信息。”

這(zhè)封公開(kāi)信可以看做是今年早些時候馬斯克公開(kāi)信的加強版和“清白版”。

此前,馬斯克聯合超過(guò)千名産業界和學(xué)術界的大佬們在“生命未來研究所(Future of Life Institute)”網站上發(fā)布聯名公告。公開(kāi)信中主要傳達了兩(liǎng)個方面(miàn)的信息:一是警告人工智能(néng)存在對(duì)人類社會的潛在威脅,要求立刻暫停任何比GPT-4更強大的人工智能(néng)系統的訓練,時間跨度至少6個月。二是呼籲整個人工智能(néng)領域以及政策制定者們,要共同設計一套全面(miàn)的人工智能(néng)治理系統,對(duì)人工智能(néng)技術的發(fā)展進(jìn)行監督和審查。

這(zhè)封信當時在多個層面(miàn)受到批評。不僅因爲馬斯克被(bèi)爆出“不講武德”,一邊公開(kāi)呼籲暫停AI研究,一邊偷偷推進(jìn)一個全新的AI項目,并挖走了一些Google和OpenAI的技術人才,還(hái)因爲“暫停開(kāi)發(fā)”的建議并不可行,而且也并不能(néng)解決問題。

比如當年跟Yoshua Bengio一起(qǐ)獲得圖靈獎,人工智能(néng)“三巨頭”之一的Yann LeCun當時就明确表示他并不同意這(zhè)封信的觀點,也沒(méi)有簽名。

不過(guò),此次這(zhè)封全新的更爲含糊的公開(kāi)信,Yann LeCun同樣(yàng)沒(méi)有簽名。

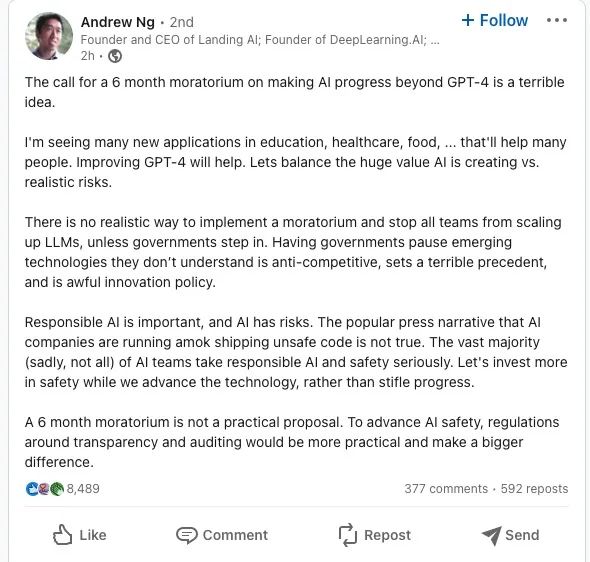

人工智能(néng)領域的著名學(xué)者、Landing AI的創始人吳恩達當時也在LinkedIn上發(fā)文表示,認爲全面(miàn)暫停AI訓練6個月的想法是一個糟糕、不切實際的想法。

他表示能(néng)夠真正讓整個行業都(dōu)暫停研究AI訓練的唯一辦法是政府的介入,但讓政府暫停他們不了解的新興技術是反競争的,顯然也不是一個很好(hǎo)的解決辦法。他承認負責任的AI很重要、AI确實也有風險,但一刀切的方式不可取。當前更重要的是各方要在發(fā)展AI技術的同時更多的投資于人工智能(néng)的安全領域,并且配合制定圍繞透明度和審計的法規。

Sam Altman更是在接受美國(guó)國(guó)會質詢的時候就直接表示,馬斯克這(zhè)個呼籲的框架是錯誤的,日期上的暫停毫無意義。“我們暫停6個月,然後(hòu)呢?我們再暫停6個月?”他說。

但和吳恩達一樣(yàng),Sam Altman一直也是要求政府加強對(duì)AI監管的最積極的呼籲者。

他甚至在聽證會上向(xiàng)美國(guó)政府提出了監管建議,要求政府組建一個新的政府機構,負責爲大型AI模型頒發(fā)許可,如果有公司模型不符合政府标準,該機構可以撤銷該公司的許可證。

上周,他還(hái)聯合了另外幾位OpenAI的高管,呼籲建立類似國(guó)際原子能(néng)機構的國(guó)際組織來監管AI,号召國(guó)際間領先的人工智能(néng)開(kāi)發(fā)商展開(kāi)合作。

和馬斯克的公開(kāi)信一樣(yàng),這(zhè)封最新的公開(kāi)信同樣(yàng)基于AI系統能(néng)力會迅速提高、但人類沒(méi)法完全控制其安全運行的假設。

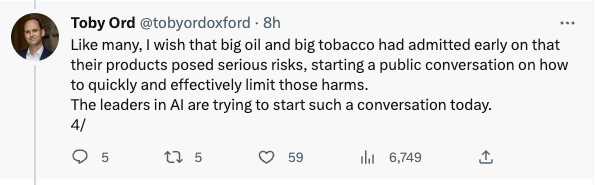

許多專家指出,大型語言模型等系統的迅速改進(jìn)是可以預見的。一旦人工智能(néng)系統達到一定的複雜程度,人類就可能(néng)無法控制它們的行爲。來自牛津大學(xué)的學(xué)者Toby Ord就表示,正如人們希望大煙草公司能(néng)夠早一點承認他們的産品會帶來嚴重的健康危害、并開(kāi)始讨論怎麼(me)限制這(zhè)些危害一樣(yàng),現在AI的領袖們正在這(zhè)麼(me)做。

但也有不少人人懷疑這(zhè)些預測。他們指出人工智能(néng)系統甚至無法處理相對(duì)平凡的任務,例如駕駛汽車等。盡管在這(zhè)一研究領域付出了多年的努力并投入了數百億美元,但全自動駕駛汽車仍遠未成(chéng)爲現實。懷疑論者說,如果人工智能(néng)連這(zhè)一挑戰都(dōu)無法應對(duì),那麼(me)在未來幾年,這(zhè)項技術有什麼(me)機會造成(chéng)威脅?

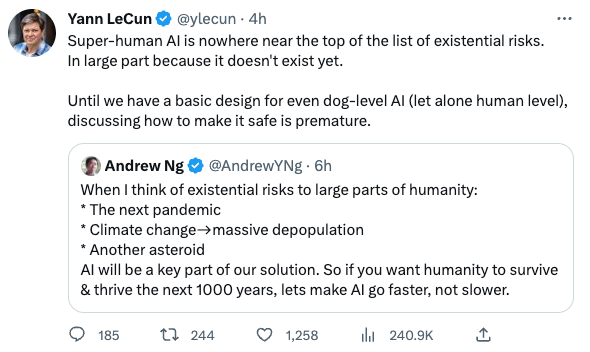

Yann LeCun就在Twitter上表達了對(duì)這(zhè)一擔憂的反對(duì),他表示,超人AI完全不在人類滅絕危機的名單前面(miàn)——主要因爲它現在還(hái)不存在。“在我們可以設計出狗這(zhè)個級别的AI(更不用說人類級别的AI了)之前,讨論如何讓它更安全完全爲時過(guò)早。”

而吳恩達對(duì)于AI持有更加樂觀的态度。他稱他眼裡(lǐ)會對(duì)大部分人類造成(chéng)生存危機的因素,包括流行病、氣候變化、小行星等,AI反而會是這(zhè)些危機的關鍵解決辦法。如果人類想要在未來1000年生存并發(fā)展,那就需要讓AI更快發(fā)展,而不是更慢。

标簽: AI

版權申明:本站文章部分自網絡,如有侵權,請聯系:hezuo@lyzg168.com

特别注意:本站所有轉載文章言論不代表本站觀點,本站所提供的攝影照片,插畫,設計作品,如需使用,請與原作者聯系,版權歸原作者所有

輸入您的聯系信息,我們將(jiāng)盡快和你取得聯系!

Tel:15137991270

企業QQ:210603461

Emile:hezuo@lyzg168.com

地址:洛陽市西工區王城大道(dào)221号富雅東方B座1711室

網站:https://www.lyzg168.com

我們的微信

關注兆光,了解我們的服務與最新資訊。

Copyright © 2018-2019 洛陽霆雲網絡科技有限公司