作者: 兆光科技 發(fā)布時間: 2024/08/09 點擊: 767次

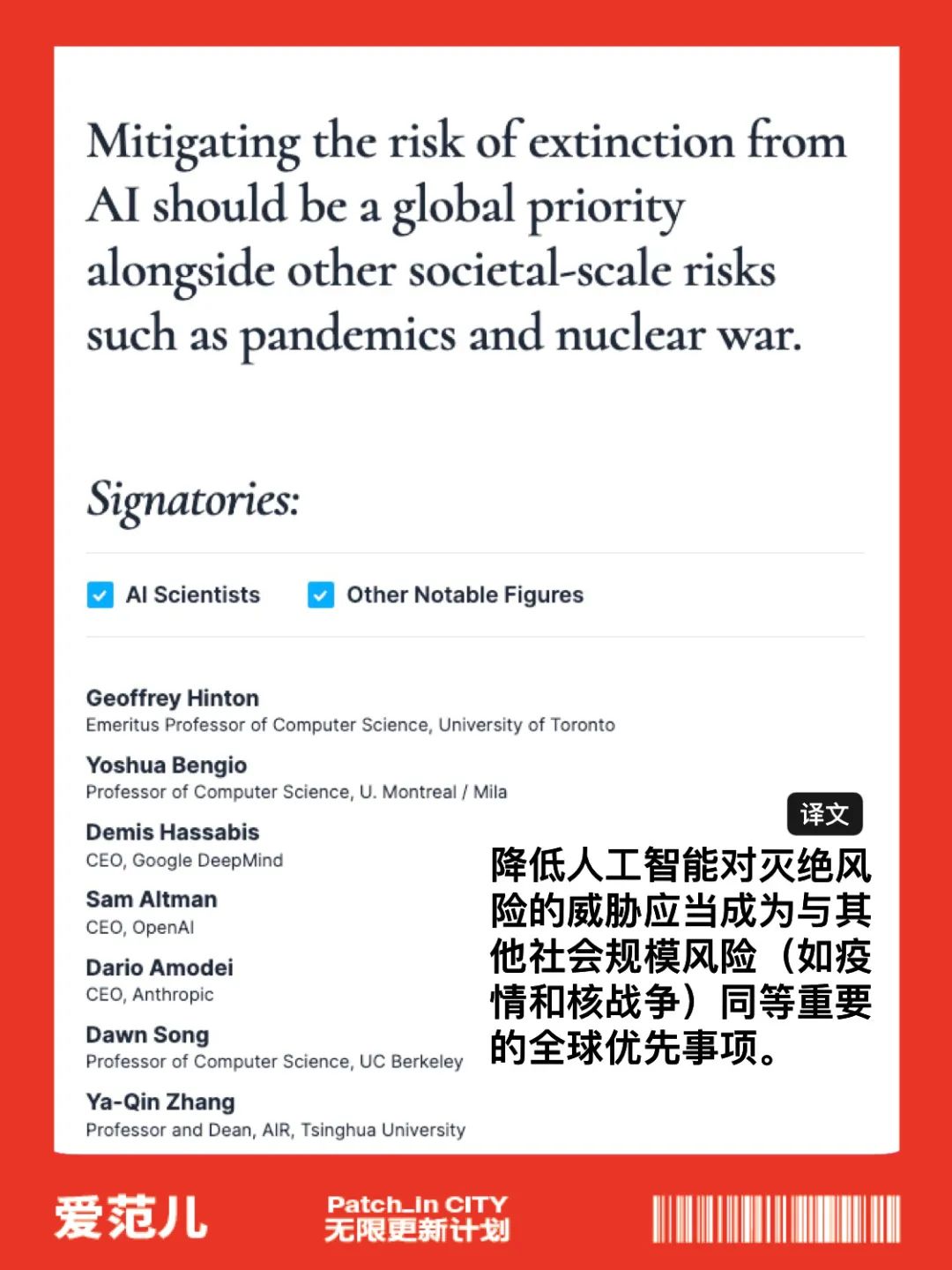

降低人工智能(néng)滅絕的風險,應該與其它社會規模的風險(如大流行病和核戰争)一樣(yàng),成(chéng)爲全球的優先事(shì)項。

就在剛剛,AI 領域傳出一封重要的公開(kāi)信。

包括 「ChatGPT 之父」Sam Altman 在内 350 位 AI 權威都(dōu)簽署了這(zhè)封聯名公開(kāi)信,并對(duì)當前正在開(kāi)發(fā)的 AI 技術可能(néng)會對(duì)人類構成(chéng)生存威脅擔憂。

這(zhè)封信隻有一句聲明:

降低人工智能(néng)滅絕的風險,應該與其它社會規模的風險(如大流行病和核戰争)一樣(yàng),成(chéng)爲全球的優先事(shì)項。

加入公開(kāi)信簽名

https://www.safe.ai/statement-on-ai-risk

簽署人包括三個領先的 AI 公司高管:

OpenAI 首席執行官 Sam Altman; Google DeepMind 首席執行官 Demis Hassabis; Anthropic 的首席執行官 Dario Amodei;

更重要的是,名單裡(lǐ)還(hái)有 Geoffrey Hinton 和 Yoshua Bengio 兩(liǎng)位人工智能(néng)的「教父」。

超過(guò) 350 名從事(shì)人工智能(néng)工作的高管、研究人員和工程師簽署了這(zhè)份由非盈利組織人工智能(néng)安全中心發(fā)布的公開(kāi)信,認爲人工智能(néng)具備可能(néng)導緻人類滅絕的風險,應當將(jiāng)其視爲與流行病和核戰争同等的社會風險。

如今人們越來越擔心 ChatGPT 等人工智能(néng)模型的發(fā)展可能(néng)對(duì)社會和就業帶來的潛在威脅,很多人呼籲針對(duì) AI 行業進(jìn)行更強力的監管,否則它將(jiāng)對(duì)社會造成(chéng)不可挽回的破壞。

AI 不斷狂飙,但相關的監管、審計手段卻遲遲沒(méi)有跟上,這(zhè)也意味著(zhe)沒(méi)有人能(néng)夠保證 AI 工具以及使用 AI 工具的過(guò)程中的安全性。

在上周,Sam Altman 和另外兩(liǎng)位 OpenAI 的高管提出應該建立類似國(guó)際原子能(néng)機構這(zhè)樣(yàng)國(guó)際組織來安全監管 AI 的發(fā)展,他呼籲國(guó)際間領先的人工智能(néng)制造商應該展開(kāi)合作,并要求政府強化對(duì)尖端人工智能(néng)制造商的監管。

其實早在 3 月,就一篇有關叫(jiào)停 6 個月 AI 研究的公開(kāi)信火遍了全網。

該信呼籲所有的 AI 實驗立即暫停研究比 GPT-4 更先進(jìn)的 AI 模型,暫停時間至少 6 個月,爲的就是把這(zhè)些可怕的幻想扼殺在搖籃之中。

該聯名信已經(jīng)獲得了包括 2018 年圖靈獎得主 Yoshua Bengio、馬斯克、史蒂夫 · 沃茲尼亞克、Skype 聯合創始人、Pinterest 聯合創始人、Stability AI CEO 等多位知名人士的簽名支持,聯名人數超過(guò)千人。

公開(kāi)信的原文如下:

人工智能(néng)具有與人類競争的智能(néng),這(zhè)可能(néng)給社會和人類帶來深刻的風險,這(zhè)已經(jīng)通過(guò)大量研究得到證實,并得到了頂級AI實驗室的認可。正如廣泛認可的阿西洛馬爾人工智能(néng)原則(Asilomar AI Principles)所指出的,先進(jìn)的 AI 可能(néng)代表地球生命曆史上的重大變革,因此應該以相應的關注和資源進(jìn)行規劃和管理。

不幸的是,即使在最近幾個月, AI 實驗室在開(kāi)發(fā)和部署越來越強大的數字化思維方面(miàn)陷入了失控的競争,而沒(méi)有人能(néng)夠理解、預測或可靠地控制這(zhè)些數字化思維,即使是它們的創造者也無法做到這(zhè)一點。

現代 AI 系統現在已經(jīng)在通用任務方面(miàn)具有與人類競争的能(néng)力,我們必須問自己:

我們應該讓機器充斥我們的信息渠道(dào),傳播宣傳和謊言嗎?

我們應該將(jiāng)所有工作都(dōu)自動化,包括那些令人滿足的工作嗎?

我們應該發(fā)展可能(néng)最終超過(guò)、取代我們的非人類思維嗎?

我們應該冒失控文明的風險嗎?

這(zhè)些決策不應該由非選舉産生的科技領導人來負責。隻有當我們确信AI系統的影響是積極的,風險是可控的,我們才應該開(kāi)發(fā)強大的AI系統。這(zhè)種(zhǒng)信心必須得到充分的理由,并随著(zhe)系統潛在影響的增大而增強。OpenAI 最近關于人工智能(néng)的聲明指出:「在某個時候,可能(néng)需要在開(kāi)始訓練未來系統之前獲得獨立審查,對(duì)于最先進(jìn)的努力,需要同意限制用于創建新模型的計算增長(cháng)速度。」我們同意。現在就是那個時刻。

因此,我們呼籲所有 AI 實驗室立即暫停至少 6 個月的時間,不要訓練比 GPT-4 更強大的 AI 系統。這(zhè)個暫停應該是公開(kāi)和可驗證的,并包括所有關鍵參與者。如果無法迅速實施這(zhè)樣(yàng)的暫停,政府應該介入并實行一個暫禁令。

AI 實驗室和獨立專家應該利用這(zhè)個暫停時間共同制定和實施一套共享的先進(jìn) AI 設計和開(kāi)發(fā)安全協議,這(zhè)些協議應該由獨立的外部專家嚴格審核和監督。

這(zhè)些協議應确保遵守它們的系統在合理懷疑範圍之外是安全的[4]。這(zhè)并不意味著(zhe)暫停 AI 發(fā)展,而隻是從不斷邁向(xiàng)更大、不可預測的黑箱模型及其突現能(néng)力的危險競賽中退一步。

AI 研究和開(kāi)發(fā)應該重點放在提高現有強大、先進(jìn)系統的準确性、安全性、可解釋性、透明度、魯棒性、對(duì)齊、可信度和忠誠度。

與此同時,AI 開(kāi)發(fā)者必須與政策制定者合作,大力加速 AI 治理體系的發(fā)展。這(zhè)些至少應包括:

專門負責 AI 的新的、有能(néng)力的監管機構;

對(duì)高能(néng)力 AI 系統和大型計算能(néng)力池的監督和跟蹤;

用于區分真實與合成(chéng)内容、跟蹤模型洩漏的溯源和水印系統;

健全的審計和認證生态系統;對(duì) AI 造成(chéng)的損害承擔責任;

技術AI安全研究的充足公共資金;

應對(duì) AI 引起(qǐ)的巨大經(jīng)濟和政治變革(特别是對(duì)民主制度的影響)的資深機構。

人類可以在 AI 的幫助下享受繁榮的未來。在成(chéng)功創造出強大的 AI 系統之後(hòu),我們現在可以享受一個「AI 盛夏」,在其中我們收獲回報,將(jiāng)這(zhè)些系統明确地用于造福所有人,并讓社會有機會适應。

在面(miàn)臨可能(néng)對(duì)社會造成(chéng)災難性影響的其他技術上,社會已經(jīng)按下了暫停鍵[5]。在這(zhè)裡(lǐ),我們也可以這(zhè)樣(yàng)做。讓我們享受一個漫長(cháng)的 AI 盛夏,而不是毫無準備地沖向(xiàng)秋天。

标簽: AI

版權申明:本站文章部分自網絡,如有侵權,請聯系:hezuo@lyzg168.com

特别注意:本站所有轉載文章言論不代表本站觀點,本站所提供的攝影照片,插畫,設計作品,如需使用,請與原作者聯系,版權歸原作者所有

輸入您的聯系信息,我們將(jiāng)盡快和你取得聯系!

Tel:15137991270

企業QQ:210603461

Emile:hezuo@lyzg168.com

地址:洛陽市西工區王城大道(dào)221号富雅東方B座1711室

網站:https://www.lyzg168.com

我們的微信

關注兆光,了解我們的服務與最新資訊。

Copyright © 2018-2019 洛陽霆雲網絡科技有限公司